Meta da un salto gigante en Inteligencia Artificial con Llama 3

El gigante tecnológico Meta ha puesto sobre la mesa una nueva pieza clave en el tablero de la inteligencia artificial: Llama 3, la última versión de su modelo de código abierto que supera con creces a sus predecesores en rendimiento y multimodalidad.

Más que un procesador de texto

Este titán de la IA no solo procesa texto, sino que está a punto de comprender imágenes y vídeos, abriendo un abanico de posibilidades inimaginables.

El secreto del poder de Llama 3 radica en un conjunto de datos de entrenamiento colosal, siete veces mayor que el de su predecesor, que incluye una gran dosis de código y datos en múltiples idiomas.

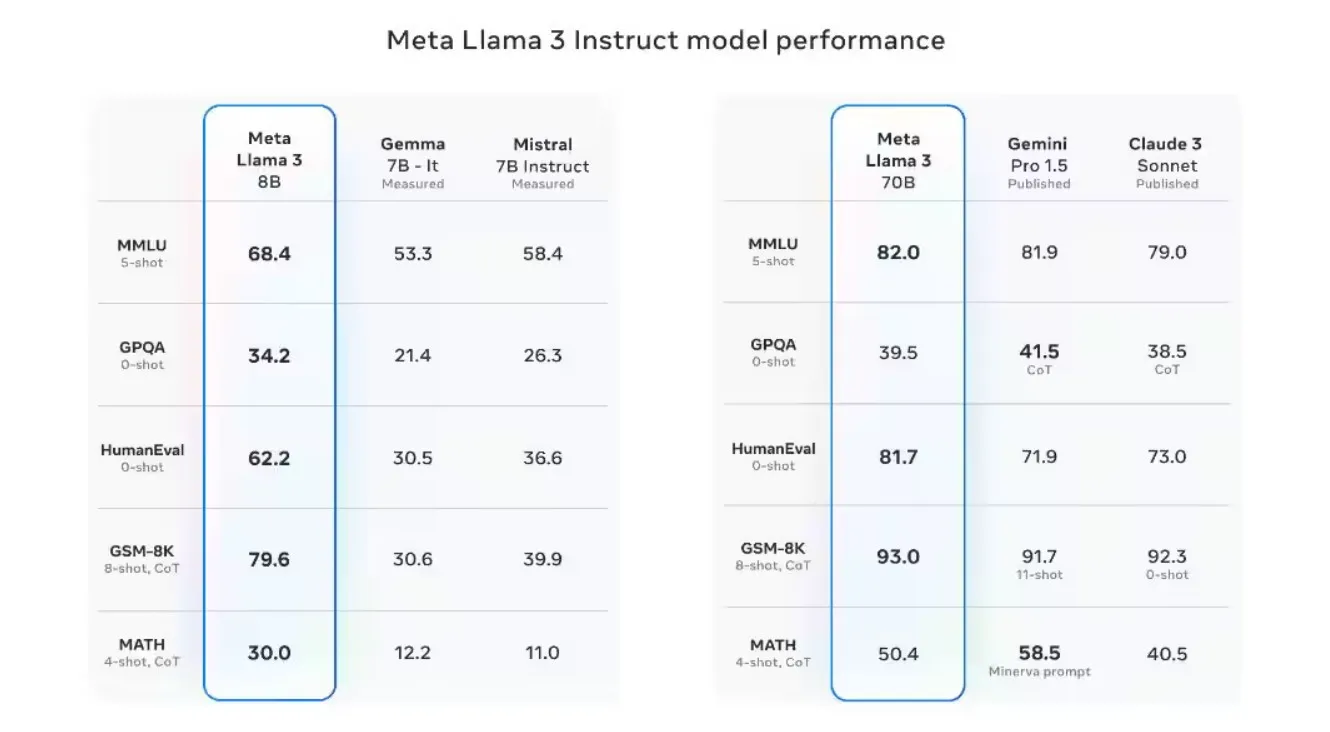

Esta expansión ha impulsado su rendimiento global de forma significativa, superando a competidores como Claude Sonnet, Mistral Medium y GPT-3.5.

Dos versiones de Llama 3

Llama 3 llega en dos versiones: un modelo de 8.000 millones de parámetros (8B) y otro de 70.000 millones (70B), ambos capaces de superar a sus rivales. Pero Meta no se detiene ahí: se espera el lanzamiento de una configuración aún más potente, con 400.000 millones de parámetros (400B).

Pero lo que realmente hace especial a Llama 3 es su accesibilidad. El modelo ya está integrado en Meta AI, el nuevo asistente de IA de la compañía, que llegará próximamente a Facebook, Instagram, WhatsApp y la web Meta.ai.

Además, Meta ha facilitado su disponibilidad en las principales plataformas en la nube, como AWS, Google Cloud y Microsoft Azure.

MetaAI llegará a su punto más alto con Llama 3

Llama 3 promete ser a Meta AI lo que GPT-4.5 es a ChatGPT, según Mark Zuckerberg, CEO de la compañía. Su objetivo es convertir a Meta AI en “el asistente de IA más inteligente y gratuito del mundo”.

Sin embargo, Zuckerberg podría estar pecando de optimismo, ya que Meta AI aún no está disponible en todo el mundo. Actualmente solo se encuentra en EEUU y, en los próximos meses, se implementará un chatbot en inglés en algunos países seleccionados.

Llama 3 también busca superar uno de los puntos débiles de su predecesor: los falsos rechazos, es decir, las veces que el modelo no puede responder a una pregunta inofensiva.

Para ello, se han mejorado los métodos de ajuste de instrucciones, afinando la precisión de las respuestas y su alineación con las intenciones del usuario. Un avance crucial para un rendimiento fiable en aplicaciones del mundo real.